728x90

728x90

from selenium import webdriver

from selenium.webdriver.chrome.service import Service

from selenium.webdriver.common.by import By

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as EC

import collections

import re

chromedriver_path = "/Users/inseoulmate/Downloads/chromedriver-mac-arm64/chromedriver"

service = Service(chromedriver_path)

driver = webdriver.Chrome(service=service)

articles = []

page = 1

while page <= 60: # Limit data collection to 60 pages

url = f"<https://news.naver.com/main/main.naver?mode=LSD&mid=shm&sid1=100#&date=%2000:00:00&page={page}>"

driver.get(url)

wait = WebDriverWait(driver, 30)

wait.until(EC.presence_of_element_located((By.CLASS_NAME, "sh_text")))

article_number = (page - 1) * 30 + 1

news_items = driver.find_elements(By.CLASS_NAME, "sh_text")

for item in news_items:

try:

press = item.find_element(By.CLASS_NAME, "sh_text_press").text

except:

press = ""

try:

headline = item.find_element(By.CLASS_NAME, "sh_text_headline").text

except:

headline = ""

try:

preview = item.find_element(By.CLASS_NAME, "sh_text_lede").text

except:

preview = ""

try:

link = item.find_element(By.CLASS_NAME, "sh_text_headline").get_attribute("href")

except:

link = ""

article = {

"번호": article_number,

"언론사": press,

"기사 제목": headline,

"미리보기 내용": preview,

"기사 링크": link

}

articles.append(article)

article_number += 1

more_button = driver.find_element(By.XPATH, "//a[contains(@class, 'cluster_more_inner')]")

if "more" in more_button.get_attribute("class"):

driver.execute_script("arguments[0].click();", more_button)

page += 1

else:

break

driver.quit()

text = " ".join([article["기사 제목"] + " " + article["미리보기 내용"] for article in articles])

def extract_keywords(text, num_top_keywords=10):

words = re.findall(r'\\w+', text.lower())

counter = collections.Counter(words)

return counter.most_common(num_top_keywords)

top_keywords = extract_keywords(text, num_top_keywords=10)

print("가장 많이 나온 키워드 Top 10:")

for keyword, count in top_keywords:

print(f"{keyword}: {count}회")

print("\\n기사 목록:")

for article in articles:

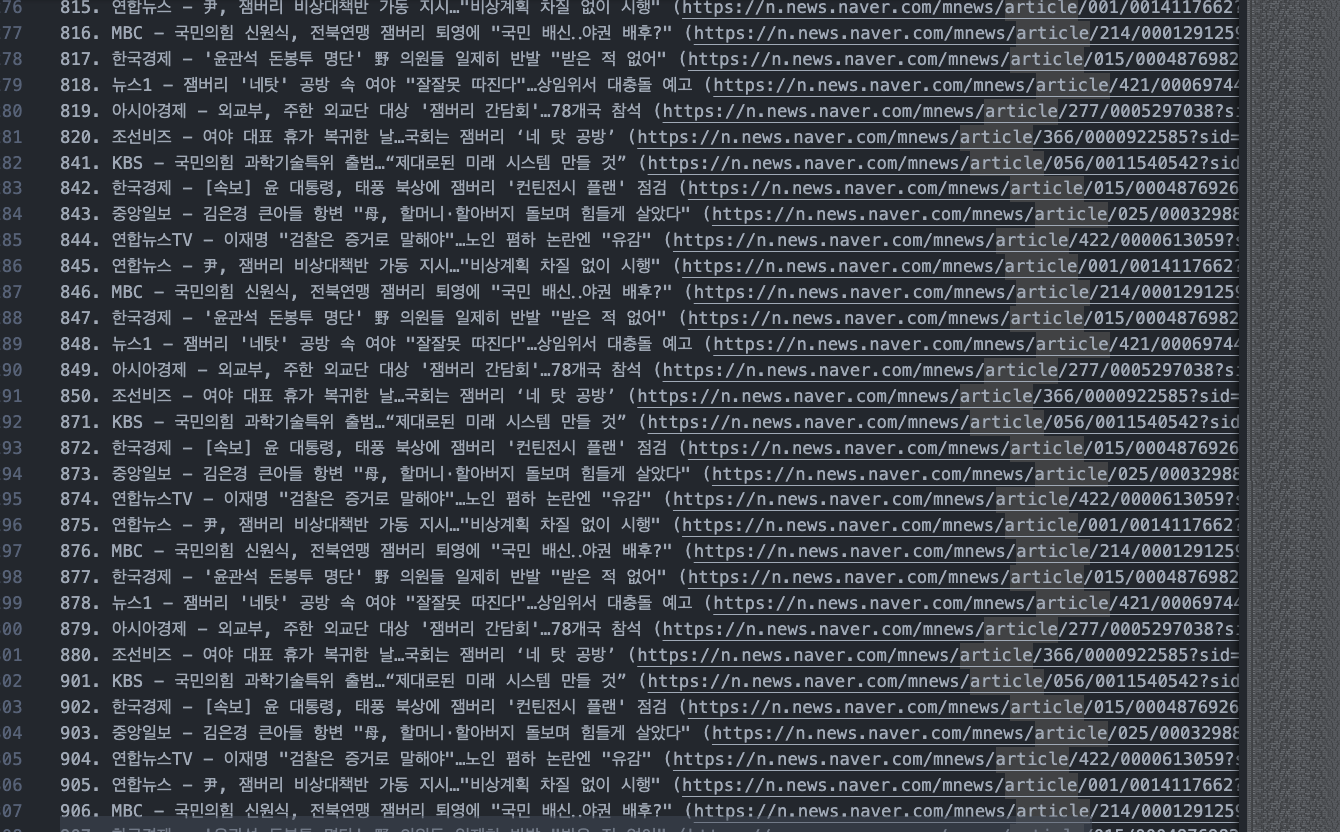

print(f"{article['번호']}. {article['언론사']} - {article['기사 제목']} ({article['기사 링크']})")

keywords_str = "가장 많이 나온 키워드 Top 10:\\n"

for keyword, count in top_keywords:

keywords_str += f"{keyword}: {count}회\\n"

with open("top_keywords.txt", "w", encoding="utf-8") as file:

file.write(keywords_str)

articles_str = "기사 목록:\\n"

for article in articles:

articles_str += f"{article['번호']}. {article['언론사']} - {article['기사 제목']} ({article['기사 링크']})\\n"

with open("articles_list.txt", "w", encoding="utf-8") as file:

file.write(articles_str)

코드 전문이다.

지난번에 셀레니움 맛보기로 지니뮤직 순위 스크래핑을 해보았는데, 이번에는 셀레니움가지고 네이버 뉴스를 스크래핑해보았다. 조금 더 기능을 구현하고 싶어서 텍스트 파일로 저장하고 , 가장 많이 나온 키워드들을 찾아 몇 회 나왔는지 정리해보는 과정까지 해보았다

- WebDriverWait: WebDriverWait 클래스를 이용하여 driver 객체를 최대 30초까지 기다리며, 해당 시간 내에 By.CLASS_NAME 으로 지정된 "sh_text" 클래스가 웹페이지에 나타날 때까지 기다리도록 한다.

- driver.find_elements: 웹페이지에서 "sh_text" 클래스를 갖는 모든 요소들을 찾습니다. 지니뮤직을 스크래핑 했을때와 비슷하게 By.CLASS_NAME을 사용했다.

- 반복문을 적용해주었다.

- article 딕셔너리에 정보들을 추가했고, 이 딕셔너리를 articles 리스트에 추가해주었다. 모든 기사의 정보를 담고 있다.

💡 헤드라인 더보기 버튼을 클릭하지 않으면 5개까지만 스크랩이 가능했다. 헤드라인 더보기 버튼을 클릭해야 나머지 5개의 기사가 나왔기 때문이다.

- 헤드라인 더보기" 버튼 클릭: 페이지의 끝까지 스크롤해서 "헤드라인 더보기" 버튼을 찾아야 했다. 있는 경우도 있었고 없는 경우도 있었기 때문이다. 버튼이 존재하면 driver.execute_script 메서드를 사용하여 JavaScript를 실행시켜 버튼을 클릭한다. 이렇게 하여 다음 페이지로 이동하여 뉴스를 추가로 스크래핑 하도록 하였다

- 페이지 수 카운팅: 스크래핑이 끝난 후 page 변수에 1을 더해서 다음 페이지로 이동하게 해두었다. 정말 많은 페이지가 있었기에 60페이지만 할 수 있도록 하였다. 60장을 모두 스크래핑하면 다음 페이지로 넘어간다.

- 드라이버를 종료해주었다. 자원을 효율적으로 사용하고 브라우저를 종료해주어야 했기 떄문이다

- 키워드 분석 및 결과 출력: 모든 기사의 제목과 미리보기 내용을 합쳐서 문자열로 만든 후, extract_keywords 함수를 사용하여 가장 많이 등장하는 단어 10개를 찾아낸다. 정규표현식 **re.findall(r'\\w+', text.lower())**을 사용하여 텍스트 데이터에서 단어만 추출하고, 단어들의 빈도를 세는 데에 **collections.Counter()**를 사용했다.

- 마지막으로 결과를 텍스트 파일로 저장해주었다. 이때 문자열 형식으로 저장해야 했는데, 파일 인코딩은 “UTF-8”로 해주었다.

텍스트 파일에 잘 저장된 모습이다. 1000개 이상 스크래핑해보았다.

오늘자 뉴스에서 제일 많이 나온 단어는 '잼버리' 였다! 잼버리 논란 진짜 많던데... 잘 해결되었으면 좋겠다 !

728x90

300x250

'2023 공부한것들' 카테고리의 다른 글

| 모든 맥북 가능 ! 윈도우 무료 설치하기 (가상머신 VM WARE) (M1,M2,X86 에러 등 다 해결함!) (1) | 2023.08.20 |

|---|---|

| 8. selenium 실습하기 - 네이버 로그인 자동화 (0) | 2023.08.08 |

| 6. selenium 맛보기 - 지니 뮤직 순위 스크래핑 (크롬 드라이버 버전 오류) (1) | 2023.08.08 |

| 5. 웹 크롤링과 스크래핑 로드맵 (0) | 2023.08.07 |

| 4. selenium을 공부해보자 (0) | 2023.08.07 |